🎉 限时特惠活动公告、获取优惠码、最高立减3200元

🤖 ChatGLM本地模型部署

🚀 ChatGLM2-6B

📖 ChatGLM2-6B 简介

ChatGLM2-6B 权重对学术研究完全开放,在获得官方的书面许可后,亦允许商业使用。本教程只是介绍了一种用法,无权给予任何授权!

:::

💻 推荐配置

| 类型 | 内存 | 显存 | 硬盘空间 |

|---|---|---|---|

| fp16 | >=16GB | >=16GB | >=25GB |

| int8 | >=16GB | >=9GB | >=25GB |

| int4 | >=16GB | >=6GB | >=25GB |

🛠️ 源码部署

💡 提示

可参考的部署文章: https://blog.csdn.net/lovelylord/article/details/132349967

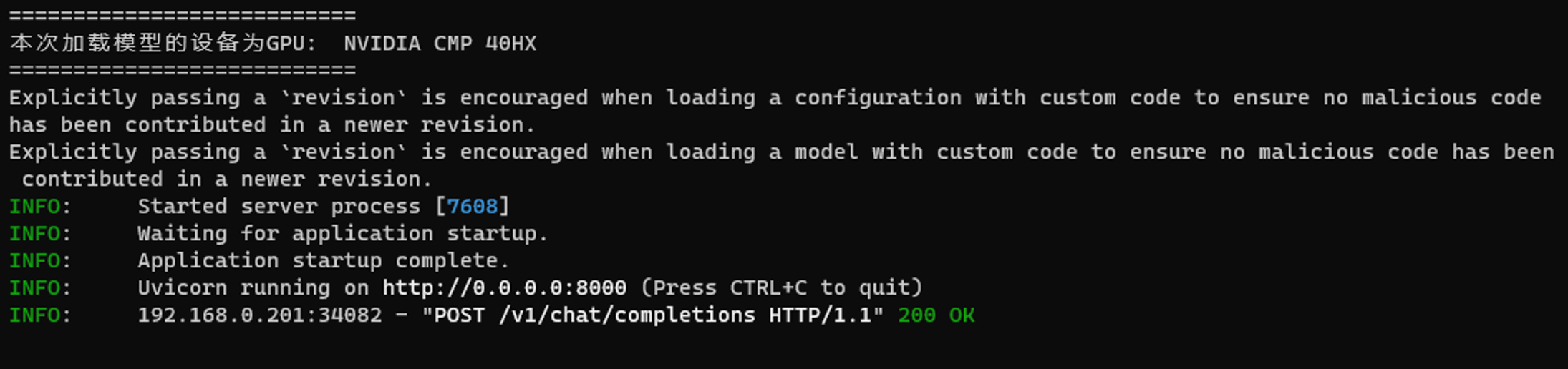

pip install -r requirments.txtpython openai_api.py --model 16 这里的数字根据上面的配置进行选择。💡 提示

⚙️ 关于 openai_api.py 启动参数

| 参数名 | 可选值 | 默认值 |

|---|---|---|

| --device | cuda=显卡运行, cpu=cpu运行 | cuda |

| --path | local=本地下载的模型运行, thudm=线上自动下载 | thudm |

| --model | 4=chatglm2-6b-int4, 8=chatglm2-6b-int8, 16=chatglm2-6b | 16 |

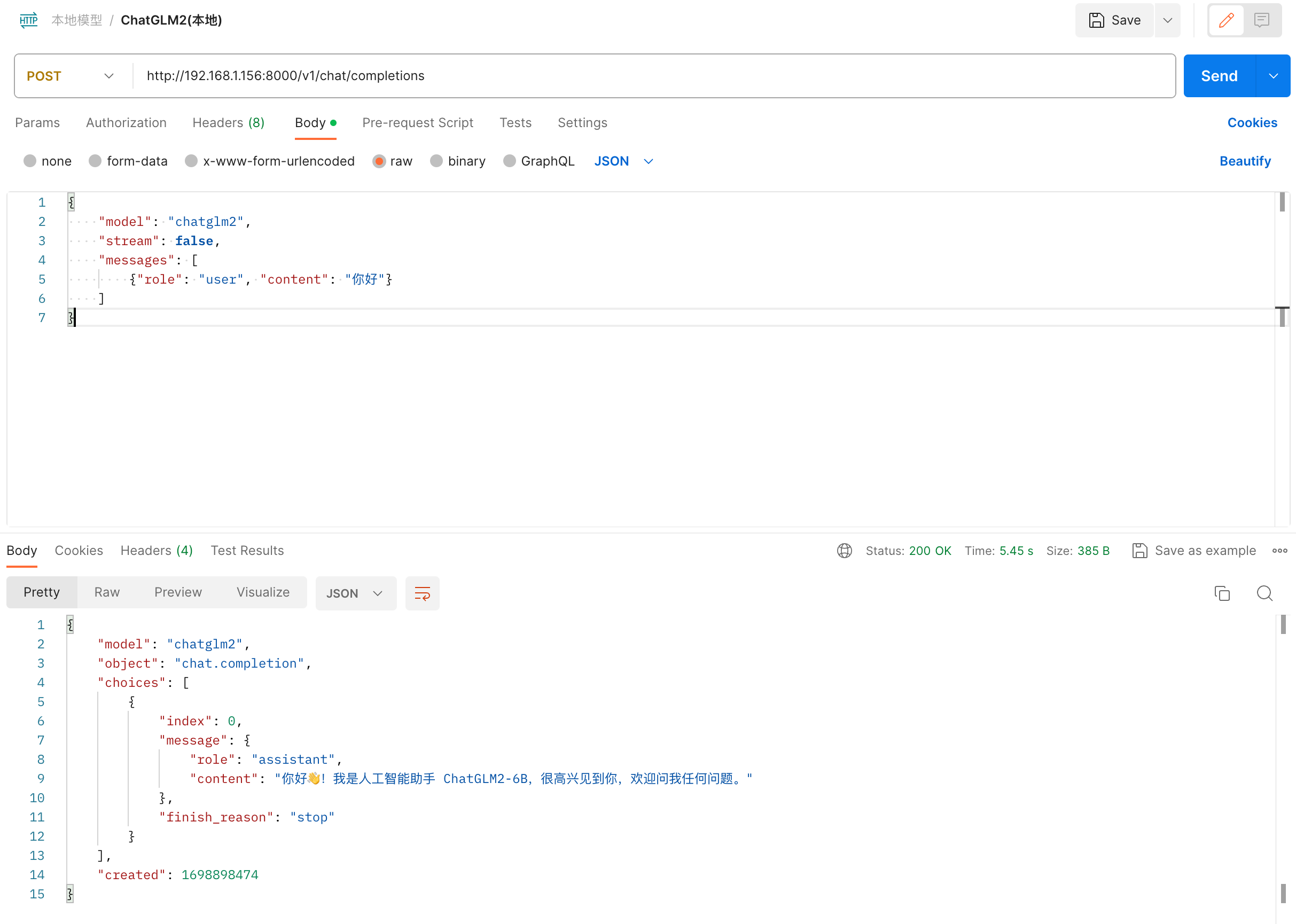

--path 参数设置为 local, 那需要你先把模型下载下来, 放到 ChatGLM2-6B/models 目录下python openai_api.py --model 4 --path local🧪 接口测试

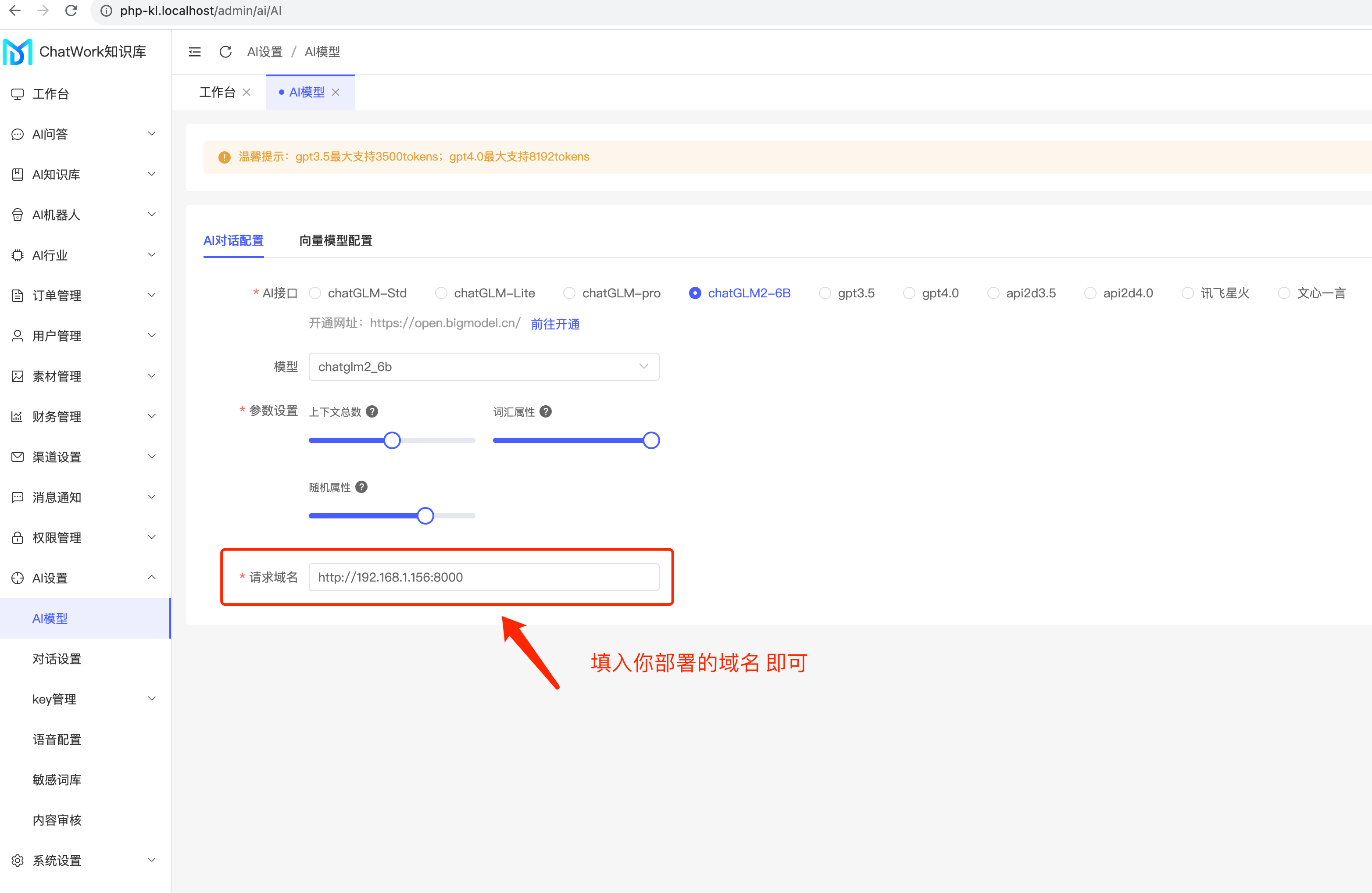

🔗 接入到系统

🚀 ChatGLM3-6B

部署方案和ChatGLM2-6B的方式基本上是一样的。

:::

| 参数名 | 可选值 | 默认值 |

|---|---|---|

| --device | cuda=显卡运行, cpu=cpu运行 | cuda |

| --path | local=本地下载的模型运行, thudm=线上自动下载 | thudm |

| --model | 4=量化模型, 16=chatglm3-6b, 32=chatglm2-6b-32k, 128=chatglm2-6b-32k | 4 |

--path 参数设置为 local, 那需要你先把模型下载下来, 放到 ChatGLM2-6B/models 目录下python openai_api.py --model 4 --path local